- 品牌

- Nvidia

- 型号

- H100

- 磁盘阵列

- Raid10

- CPU类型

- Intel Platinum 8558 48 核

- CPU主频

- 2.10

- 内存类型

- 64G

- 硬盘容量

- Samsung PM9A3 7.6TB NVMe *8

- 厂家

- SuperMicro

- 标配CPU个数

- 2个

- 最大CPU个数

- 4个

- 内存容量

- 64G*32

- GPU

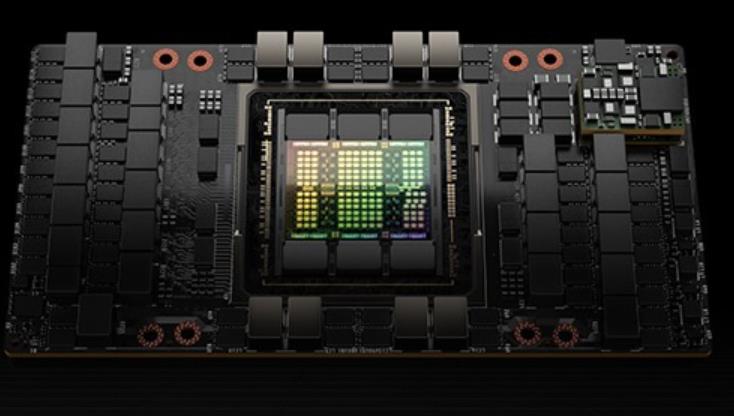

- 8 H100 80GB NVlink

在软件支持方面,H100 GPU 配套了 NVIDIA 全的开发工具和软件生态系统。NVIDIA 提供了包括 CUDA Toolkit、cuDNN、TensorRT 等在内的多种开发工具,帮助开发者在 H100 GPU 上快速开发和优化应用。此外,H100 GPU 还支持 NVIDIA 的 NGC(NVIDIA GPU Cloud)容器平台,开发者可以通过 NGC 轻松获取优化的深度学习、机器学习和高性能计算容器,加速开发流程,提升应用性能和部署效率。PCIe 4.0 接口,提供了更高的数据传输速度和带宽,与前代 PCIe 3.0 相比,带宽提升了两倍。这使得 H100 GPU 在与主机系统通信时能够更快速地交换数据,减少了 I/O 瓶颈,进一步提升了整体系统性能。H100 GPU 特价销售,赶快抢购。80GH100GPU price

在大数据分析领域,H100 GPU 展现了其强大的数据处理能力。它能够快速处理和分析海量数据,提供实时的分析结果,帮助企业做出更快的决策。无论是在金融分析、市场预测还是用户行为分析中,H100 GPU 都能提升数据处理速度和分析准确性。其高能效设计不仅提升了性能,还为企业节省了大量的能源成本,成为大数据分析的理想硬件。H100 GPU 在云计算中的应用也非常多。它的高并行处理能力和大带宽内存使云计算平台能够高效地处理大量并发任务,提升整体服务质量。H100 GPU 的灵活性和易管理性使其能够轻松集成到各种云计算架构中,满足不同客户的需求。无论是公共云、私有云还是混合云环境,H100 GPU 都能提供强大的计算支持,推动云计算技术的发展和普及。80GH100GPU priceH100 GPU 提供高效的视频编辑支持。

利用 NVIDIA H100 Tensor GPU,提供所有工作负载前所未有的效能、可扩展性和安全性。 使用 NVIDIA® NVLink® Switch 系统,比较高可连接 256 个 H100 来加速百万兆级工作负载,此外还有的 Transformer Engine,可解决一兆参数语言模型。 H100 所结合的技术创新,可加速大型语言模型速度,比前一代快上 30 倍,提供业界的对话式人工智能。英伟达 DGX SuperPOD架构采用英伟达的NVLink和NVSwitch系统,多可连接32个DGX节点,共256个H100 GPU。这是一个真正的人工智能基础设施平台;英伟达的DGX SuperPOD数据中心设计[4]让我们对真正的企业人工智能基础设施的巨大功率和冷却需求有了一些了解。

然后剩余的总共大约6个月。初创公司是否从OEM和经销商处购买?#没有。初创公司通常会去像甲骨文这样的大型云租用访问权限,或者像Lambda和CoreWeave这样的私有云,或者与OEM和数据中心合作的提供商,如FluidStack。初创公司何时构建自己的数据中心与进行托管?#对于构建数据中心,考虑因素是构建数据中心的时间,您是否具有硬件方面的人员和经验,以及它的资本支出是否昂贵。更容易租用和colo服务器。如果你想建立自己的DC,你必须在你所在的位置运行一条暗光纤线路来连接到互联网-每公里10万美元。大部分基础设施已经在互联网繁荣期间建成并支付。现在你可以租它,相当便宜–私有云执行官从租赁到拥有的范围是:按需云(使用云服务的纯租赁),保留云,colo(购买服务器,与提供商合作托管和管理服务器),自托管(自己购买和托管服务器)。大多数需要大量H100的初创公司将进行保留云或colo。大云如何比较?#人们认为,Oracle基础架构不如三大云可靠。作为交换,甲骨文会提供更多的技术支持帮助和时间。100%.一大堆不满意的客户,哈哈–私有云执行官我认为[甲骨文]有更好的网络–(不同)私有云高管一般来说,初创公司会选择提供支持、价格和容量的佳组合的人。近期 H100 GPU 的价格波动引起了关注。

ITMALL.sale 非常重视客户反馈,并不断改进其服务和产品质量。通过定期回访和客户满意度调查,ITMALL.sale 了解客户在使用 H100 GPU 过程中的需求和建议,及时解决客户遇到的问题。ITMALL.sale 还设有专门的客户服务中心,提供7x24小时的在线支持和电话咨询,确保客户在任何时候都能够获得帮助。ITMALL.sale 的目标是通过不断优化服务,提升客户满意度,成为客户心中值得信赖的 H100 GPU 供应商。ITMALL.sale 的客户服务团队经过严格培训,具备专业的技术知识和良好的服务态度,能够为客户提供全的支持和帮助。H100 GPU 适用于大数据分析任务。香港H100GPU购买

H100 GPU 优惠促销,数量有限。80GH100GPU price

每个GPU实例在整个内存系统中都有单独的和孤立的路径--片上的交叉开关端口、L2缓存库、内存控制器和DRAM地址总线都是分配给单个实例的。这保证了单个用户的工作负载可以以可预测的吞吐量和延迟运行,具有相同的L2缓存分配和DRAM带宽,即使其他任务正在冲击自己的缓存或使其DRAM接口饱和。H100MIG改进:提供完全安全的、云原生的多租户、多用户的配置。Transformer引擎Transformer模型是当今从BERT到GPT-3使用的语言模型的支柱,需要巨大的计算资源。第四代NVLink和NVLink网络PCIe以其有限的带宽形成了一个瓶颈。为了构建强大的端到端计算平台,需要更快速、更可扩展的NVLink互连。NVLink是NVIDIA公司推出的高带宽、高能效、低延迟、无损的GPU-to-GPU互连。其中包括弹性特性,如链路级错误检测和数据包重放机制,以保证数据的成功传输。新的NVLink为多GPUIO和共享内存访问提供了900GB/s的总带宽,为PCIeGen5提供了7倍的带宽。A100GPU中的第三代NVLink在每个方向上使用4个差分对(4个通道)来创建单条链路,在每个方向上提供25GB/s的有效带宽,而第四代NVLink在每个方向上使用2个高速差分对来形成单条链路,在每个方向上也提供25GB/s的有效带宽。引入了新的NVLink网络互连。80GH100GPU price

- 河南H100GPU现货 2024-12-25

- 湖南LenovoH100GPU 2024-12-25

- 80GH100GPU price 2024-12-24

- NvdiaH100GPU促销 2024-12-24

- 北京SMXH100GPU 2024-12-23

- 湖南H100GPU代理商 2024-12-23

- CPUH100GPU购买 2024-12-23

- SingaporeHPEH100GPU 2024-12-23

- 超微H100GPU折扣 2024-12-23

- TaiwanH100GPU多少钱 2024-12-20

- 技嘉H100GPU list price 2024-12-20

- SingaporeH100GPU多少钱 2024-12-19