- 品牌

- 苏州正和铝业有限公司

- 型号

- v1

单柜功率提升是液冷技术渗透的根本原因根据微软数据,ChatGPT前一代基础模型-GPT3.0的训练数据高达45TB,总训练设备包括28.5万个CPU与超过1万个NVIDIA V100 GPU。随着国内百度、阿里巴巴、腾讯、华为、360、字节等互联网大厂陆续推出自己的AIGC算力模型,势必会对国内AI服务器的需求快速增加,AI服务器中大量使用高功率CPU、GPU芯片,带动整台AI服务器功率和热密度提升。(1)CPU功耗持续提升:随着内核数量的增加,处理器性能与功率实现了同步增长,这也直接导致了CPU热流密度的相应增加和服务器机柜本内部的总体热密度增加;(2)GPU使用日益增加:GPU由数百个内核组成,可同时处理数千个线程,相应地功耗更高。(3)低延迟需求导致热密度增加:随着服务器组件性能的提高,不同组件之间的互连在延迟方面开始成为瓶颈。为了充分利用提升的组件性能,CPU、GPU和板卡上的其他组件被更加紧密的安排以减少延迟,这同样提升了服务器内部的物理密度和温度越来越高。数据中心液冷,就选正和铝业,用户的信赖之选,有想法的不要错过哦!湖南防潮数据中心液冷厂家

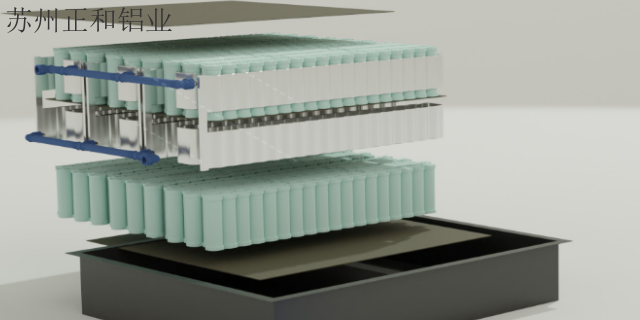

浸没式液冷浸没式液冷是常见的直接接触型液冷技术。该技术通过将发热器件直接浸没于特殊定制的箱体中,通过直接接触不导电的冷却液体进行热交换,从而达到冷却目的,相比冷板式液冷技术,浸没式液冷散热效率更高,噪音更低(完全没有风扇),更加节能。单相浸没式液冷中冷却液不会发生相变。单相浸没在浸没式单相液冷中,发热部件直接浸没在冷却液中进行热交换,循环泵将吸收了热量的冷却液导入热交换单元,在热交换单元中冷却后再循环回到箱体中为发热部件散热,冷却液在循环散热过程中始终保持液相。浙江品质保障数据中心液冷生产厂家数据中心液冷的大概费用是多少?

液冷技术改变数据中心的建设。在业务需求相同的情况下,新建数据中心由于限制少和政策支持,适宜应用液冷方案。扩建数据中心需要选定适当比例的空间兼容液冷,提升整体运行效率。改建数据中心则需根据机房楼板承重,视实际情况进行机房的加固,为液冷留出适度裕量。液冷技术改变数据中心的交付。液冷数据中心的交付要充分考虑设备冷却液的品质:除了传热效率等液体性质的评估要达标,还需要符合我国相关消防规范及地方标准,以及设备需采用PTFE或其他抗腐蚀性更强的材料,对于管道、线材、电源模块、阀件等密封材料与冷却液的兼容性有较高要求。

全球数据中心总量缓步下降,从2016年的45万座逐步下降到2019年的42.9万座,其中小微型数据中心数量下降明显,大型和超大型数据中心数量持续增加。与此同时,全球数据中心规模不断扩大,机架总数呈增长态势,从2016年的488.9万架增长至为495.4万架。超大型数据中心增长迅速,此外,仍有151座超大型数据中心正在建设或者在规划中。经赛迪顾问估算,2020年超大型数据中心服务器占比将升至50%以上,将提供65%的数据运算能力,55%的数据存储量,从而处理50%数据流量。昆山性价比较好的数据中心液冷的公司联系电话。

随着人工智能、云计算、大数据以及区块链等技术的创新发展,使得数据资源的存储、计算和应用需求快速扩张,特别是ChatGPT技术推广进一步催生了AI算力等大功率应用场景加速落地。作为信息基础设施的数据中心及通信设备承担的计算量越来越大,对计算效率的要求也越来越高,国内包括全球的数据中心建设有望迎来建设高峰。为了应对网络处理性能的挑战,数据中心服务器及通信设备不断提升自身处理能力和集成度,带来了功率密度的节节攀升。这些变化除了带来巨额能耗问题以外,高热密度也给制冷设备和技术提出了更高要求。传统风冷技术面对高热密度场景呈现瓶颈,散热效率已经跟不上计算效率。在此背景下,液冷技术以其超高能效、超高热密度等特点引起行业的普遍关注,是解决散热压力和节能挑战的必由之路。数据中心液冷,就选正和铝业,让您满意,欢迎新老客户来电!湖北创新数据中心液冷供应

正和铝业是一家专业提供数据中心液冷的公司,有想法可以来我司咨询!湖南防潮数据中心液冷厂家

2020年3月,常务委员会提出了加快数据中心等新型基础设施建设的要求。新基建是指以新发展理念为指引,以技术创新为驱动,以数据为主,以信息网络为基础,面向高质量发展需要,提供数字转型、智能升级、融合创新等服务的基础设施体系。数据中心作为基于新一代信息技术演化生成的基础设施,是算力基础设施的典型,数据中心发展迎来风口。但数据中心作为新型基础设施中的基础,其建设一直被能耗过大等环境议题所困扰,秉持绿色化发展原则已经成为了全社会的共识。提升数据中心能效,降低PUE已经成为数据中心发展的必然趋势。湖南防潮数据中心液冷厂家

- 安徽品质保障数据中心液冷工厂 2024-07-01

- 江苏防水数据中心液冷销售电话 2024-07-01

- 安徽全新数据中心液冷研发 2024-07-01

- 浙江绝缘数据中心液冷工厂 2024-07-01

- 上海创新数据中心液冷生产 2024-07-01

- 安徽水冷板数据中心液冷供应商 2024-07-01

- 北京品质保障数据中心液冷研发 2024-07-01

- 上海专业数据中心液冷生产 2024-07-01