- 品牌

- 苏州正和铝业有限公司

- 型号

- v1

在技术端,伴随着芯片能耗的提升,风冷逐渐乏力,液冷势在必行。随着ChatGPT引发新一轮人工智能应用的热潮,大模型训练、运营中对算力的需求也大幅增加,而在算力需求的背后,则是对芯片需要具备更高计算效率的渴求。进入2023年以来,英伟达发布了新的H100计算卡,而其老对手AMD也即将发布InstinctMI300显卡,为大模型与人工智能的发展提供坚实的技术底座。但计算能力的快速发展,就必然伴随着能耗的加大,据ODCC《冷板式液冷服务器可靠性白皮书》信息,2022年Intel第四代服务器处理器单CPU功耗已突破350瓦,英伟达单GPU芯片功耗突破700瓦,AI集群算力密度普遍达到50kW/柜。数据中心液冷,就选正和铝业,让您满意,欢迎您的来电!海南专业数据中心液冷生产

互联网行业的电商、社交平台、短视频等领域的企业较多,用户群体巨大,业务体量大,数据中心算力需求大,单机柜功率密度可达到10kw甚至更高,是目前液冷数据中心的客户。金融行业信息系统的云化迁移和互联网金融产品的普及对金融行业敏捷响应、业务即时变更等需求增加,金融行业液冷数据中心算力需求进一步提升。重视余热利用,提高液冷数据中心利用效率。传统数据中心对于余热的利用效率不高,液冷数据中心架构上设置了冷却液回流机制,利用该机制可以实现对供暖等生产生活用水的加热,提升数据中心的使用效率,提高营收水平。另外,余热利用在PUE计算中减少了制冷系统的散热负荷,能够有效降低PUE值。因此液冷行业应当重视余热的利用,实现效益和能耗的“双赢”。湖北防潮数据中心液冷价格数据中心液冷,就选正和铝业,用户的信赖之选,有想法可以来我司咨询!

其次是电力用户站占比20%,UPS电源设备占比18%,剩余成本项占比均低于10%;Opex结构方面,电力成本(能耗)占整体支出的一半以上,折旧其次,占比25.6%。单独将Opex中的能耗成本进行拆分来看,其中IT设备能耗高,占整体Opex的45%,散热能耗占比43%,接近IT设备自身的能耗,供电损耗及其他占比12%,能看出散热能耗对于数据中心电力成本影响极大,随着IT相关设备功率密度的提升,对设施的散热要求也更加苛刻,因此采用高效的液冷手段是数据中心发展的必经之路。

超大型数据中心飞速发展和空间载体不足将加快单机柜功率密度的迅猛提升,预计2025年平均功率可达25kW。快速增长的功率密度对散热提出了更高要求。据统计,2019年以”风冷散热”技术为主要的传统数据中心,其耗能中约有43%是用于IT设备的散热,与IT设备自身的能耗(45%)基本持平,PUE(评价能源效率指标)值普遍在1.4以上,由此可见,降低散热功耗、控制数据中心运营成本,建设绿色数据中心已成当务之急,数据中心呼唤散热”进步”。哪家的数据中心液冷的价格优惠?

液冷数据中心有五大优势:一,液冷技术的高效制冷可有效提升服务器的使用效率和稳定性。液体传导热能效果更好,是空气的25倍,温度传递效果更快、更优,能够实现IT设备高效制冷。同时,由于液体的比热容大,在吸收大量热量后自身温度不会产生明显的变化,故而能够定CPU温度。即使服务器遇到突发操作,运行功率激增也不会引起CPU内部温度大幅升高,保障CPU在一定范围内进行超频工作不会出现过热故障。第二,应用液冷技术有助于实现数据中心节能、降噪。首先,液冷数据中心与传统风冷数据 中心相比,去掉了空调系统以及对应的风冷基础设施,增加了循环泵,能够节约建设成本。正和铝业为您提供数据中心液冷,期待为您!海南水冷板数据中心液冷批发厂家

昆山口碑好的数据中心液冷公司。海南专业数据中心液冷生产

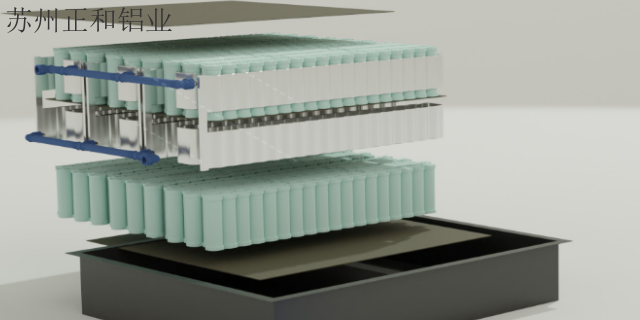

冷板式液冷数据中心散热系统主要由由室外(一次侧)和室内(二次侧)两部分组成。一次侧通过冷却液体与发热部件的热量进行相互交换的方式降低冷却液的温度;二次侧完成发热部件与冷却液体热量的交换,液体升温带走部件热量。在运行过程中,机房外冷却塔中的冷却液通过室内冷量分配单元(CDU)提供冷却液循环动力,经其二次侧输出并与服务器中高发热量的电子元器件(CPU、GPU、内存等)导热冷板直接进行热交换,形成的热液经CDU输出到室外冷却塔进行冷却,从而构成整个循环过程,在冷板式液冷散热方式中,硬盘、电源等发热量较小的器件或单元仍旧采用风冷方式散热。海南专业数据中心液冷生产

- 安徽品质保障数据中心液冷工厂 2024-07-01

- 江苏防水数据中心液冷销售电话 2024-07-01

- 安徽全新数据中心液冷研发 2024-07-01

- 浙江绝缘数据中心液冷工厂 2024-07-01

- 上海创新数据中心液冷生产 2024-07-01

- 安徽水冷板数据中心液冷供应商 2024-07-01

- 北京品质保障数据中心液冷研发 2024-07-01

- 上海专业数据中心液冷生产 2024-07-01