- 品牌

- 苏州正和铝业有限公司

- 型号

- v1

其中浸没式液冷数据中心凭借其优良的制冷效果,市场份额增长速度较快。互联网、金融、电信等领域对数据中心液冷的需求量将会持续加大。预计到2025年,互联网行业液冷数据中心占比将达到24.0%,金融行业将达到25.0%,电信行业将达到23.0%。而能源、生物、医疗等将行业需求将加快融入通用数据中心新业态,整体上规模有所下降。预计2025年能源行业液冷数据中心占比将达到10.5%,金融行业将达到8.5%,电信行业将达到6.5%,其他业务将下降至2.5%。正和铝业为您提供数据中心液冷,有想法的不要错过哦!上海耐高温数据中心液冷定做

单柜功率提升是液冷技术渗透的根本原因根据微软数据,ChatGPT前一代基础模型-GPT3.0的训练数据高达45TB,总训练设备包括28.5万个CPU与超过1万个NVIDIA V100 GPU。随着国内百度、阿里巴巴、腾讯、华为、360、字节等互联网大厂陆续推出自己的AIGC算力模型,势必会对国内AI服务器的需求快速增加,AI服务器中大量使用高功率CPU、GPU芯片,带动整台AI服务器功率和热密度提升。(1)CPU功耗持续提升:随着内核数量的增加,处理器性能与功率实现了同步增长,这也直接导致了CPU热流密度的相应增加和服务器机柜本内部的总体热密度增加;(2)GPU使用日益增加:GPU由数百个内核组成,可同时处理数千个线程,相应地功耗更高。(3)低延迟需求导致热密度增加:随着服务器组件性能的提高,不同组件之间的互连在延迟方面开始成为瓶颈。为了充分利用提升的组件性能,CPU、GPU和板卡上的其他组件被更加紧密的安排以减少延迟,这同样提升了服务器内部的物理密度和温度越来越高。浙江数据中心液冷正和铝业是一家专业提供数据中心液冷的公司,有想法可以来我司咨询!

而为了应对网络处理性能的挑战,数据中心服务器及通信设备不断提升自身处理能力和集成度,功率密度节节攀升。而这些变化除了带来巨额能耗问题以外,高热密度也给制冷设备和技术提出了更高要求。如何能在政策严格限制PUE(PowerUsageEffectiveness)的情况下,仍旧保证散热能力的不缺失,成为了摆在所有数据中心前面的一道难题。在此背景下,作为风冷的进阶版本,液冷凭借其超高能效、散热等特点引起行业的普遍关注,并逐渐成为散热的新方向。

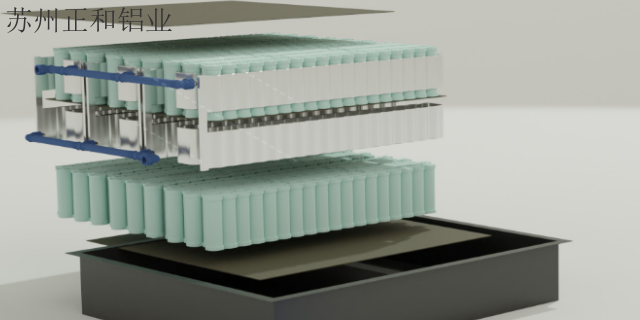

冷板式液冷冷板式液冷是典型的间接式接触型液冷技术。冷板式液冷系统包括了水冷板、管道、快插接头、分液器、冷却液分配单元(CDU)与室外冷却设备等组件。在冷板式液冷系统中,服务器芯片等发热器件不直接接触冷却液,而是通过与装有液体的冷板直接接触来散热,或者由导热部件将热量传导到冷板上(冷板通常是由铜、铝等高导热金属构成的封闭腔体),然后通过冷板内部液体循环带走热量。由于服务器芯片等发热器件不用直接接触液体,所以冷板式液冷对现有服务器芯片组件及附属部件改动量较小,可操作性更强、目前成熟度高、应用普遍。正和铝业是一家专业提供数据中心液冷的公司,欢迎您的来电哦!

整个冷板式液冷系统也可分为两部分,室外侧循环和室内侧循环。其中,室内侧循环热量转移主要是通过冷却液温度的升降实现,而室外侧循环中,热量转移主要是通过水温的升降实现。根据本次研究对数据中心相关企业的调研结果,相比传统风冷,冷板式、浸没非相变和浸没相变冷却效果更好。除了初期投入成本和承重要求外,液冷表现均优于传统风冷。在传统的风冷不能满足的情况下,该数据中心配置了联想的冷板式液冷设备,水被送入服务器冷板,在组件周围循环,然后吸收热量离开冷板,进入冷源实现冷却。正和铝业致力于提供数据中心液冷,有需要可以联系我司哦!上海耐高温数据中心液冷定做

正和铝业致力于提供数据中心液冷,有需求可以来电咨询!上海耐高温数据中心液冷定做

液冷散热系统相较风冷更适配高性能计算服务器。鉴于传统空气冷却系统的低效率,冷却能耗高,噪音大,以及考虑冷却CPU和GPU的技术需求,风冷技术已无法满足数据中心日益增长的散热需求,更高性能、更低能耗的液冷系统或成为未来主流散热方式。2020年阿里巴巴部署全球规模超大的浸没式液冷数据中心节约能耗很多可达70%,阿里“浸没式液冷服务器集群”的PUE值逼近理论极限值1.0,而当时业界以风冷为散热系统的数据中心的PUE都在1.6左右。上海耐高温数据中心液冷定做

- 安徽品质保障数据中心液冷工厂 2024-07-01

- 江苏防水数据中心液冷销售电话 2024-07-01

- 安徽全新数据中心液冷研发 2024-07-01

- 浙江绝缘数据中心液冷工厂 2024-07-01

- 上海创新数据中心液冷生产 2024-07-01

- 安徽水冷板数据中心液冷供应商 2024-07-01

- 北京品质保障数据中心液冷研发 2024-07-01

- 上海专业数据中心液冷生产 2024-07-01