- 品牌

- 苏州正和铝业有限公司

- 型号

- v1

- 加工定制

- 是

近年来,我国数据中心绿色发展进程日益加快,数据中心的能效水平不断提高,电源使用效率(PowerUsageEffectiveness,PUE)持续降低。2019年年底全国现有超大型数据中心平均PUE为1.46,大型数据中心平均PUE为1.55;规划在建的超大型、大型数据中心平均设计PUE分别为1.36、1.39。根据工信部《新型数据中心发展三年行动计划(2021-2023年)》的文件,到2023年底,新建大型及以上数据中心PUE降低到1.3以下,我国绿色数据中心发展政策也指出,将计划降低数据中心能耗总体水平。在数据中心能耗占比中制冷系统的能耗占比为30-40%,是总能耗中占比高的数据中心基础设施模块,因此改进数据中心制冷等基础设施技术,提高制冷效率,减少制冷系统的能耗水平,成为未来发展方向。正和铝业为您提供液冷 ,有想法的可以来电咨询!北京防潮液冷价格

随着算力持续增加对芯片散热要求更高,液冷可以说是解决散热压力和节能挑战的必经之路。算力的持续增加促进通讯设备性能不断提升,芯片功耗和热流密度也在持续攀升,产品每演进一代功率密度攀升30~50%。当代X86平台CPU功耗300~400W,业界芯片热流密度已超过120W/cm2;芯片功率密度的持续提升直接制约着芯片散热和可靠性,传统风冷散热能力越来越难以为继。芯片功率密度的攀升同时带来整柜功率密度的增长,当前已超过30kW/机架;对机房制冷技术也提出了更高的挑战。液冷作为数据中心新兴制冷技术,被应用于解决高功率密度机柜散热需求。江苏品质保障液冷批发厂家液冷 ,就选正和铝业,有想法的可以来电咨询!

在5G等新技术的快速普及下,数据中心已成为数字经济发展的关键基础设施和重要支撑,数据中心的建设规模和数量快速增长,庞大的设施体量以及日益增长的算力需求使得传统风冷技术已无法满足数据中心日益增长的散热需求,液冷几乎成为未来新型数据中心建设的优良选择。6月28日,中国移动董事长杨杰在上海世界移动通信大会上指出,中国移动既是技术发展的推动者,也是产业合作的受益者,为推动算力在物理空间、逻辑空间、异构空间及多主体间融通发展,中国移动正开创性地部署算力网络,建设新型智算中心,努力为用户提供方便快捷、即取即用的算力服务。

Iceotope是在数据中心和边缘计算精密液体冷却技术领域处于先地位的英国企业,成立于2005年。迄今为止,Iceotope从Aster和OmbuGroup、nVent等金融机构和企业获得了7330万美元资金。机箱级精密浸没冷却是Iceotope液冷技术的中心,与罐式浸没解决方案相比,机箱级精密浸没可大限度地减少冷却液用量,并且可以方便地安装到行业标准机架中,提供机箱级别100%密封和液冷解决方案。机箱级浸没冷却方案部署、维护简单,不需要重型起重设备,且支持热插拔。液冷 ,就选正和铝业。

目前中国厂商对液冷服务器技术的探索已不落后于海外企业,在大规模商业应用的经验上已经处于排名靠前的地位。从竞争格局来看,海外浸没式液冷市场的主要玩家有GRC(美国)、LiquidStack(美国)、Midas(美国)等;冷板式液冷市场主要玩家有CoolITSystems(美国)、Asetek(丹麦)、Motivair(美国)等,目前主要厂商在液冷技术方面还处于实验或初步应用阶段。而以中科曙光为首的国内厂商已经积累了一定的商业化经验,据《中国液冷数据中心发展白皮书》在2020年对于中国液冷数据中心厂商竞争力的研究,基于产品营收、市占率、客户反馈等指标,华为、阿里巴巴、联想紧随其后,IBM中国位于可期待者位置。正和铝业为您提供液冷 。上海防潮液冷

正和铝业为您提供液冷 ,有需求可以来电咨询!北京防潮液冷价格

随着人工智能、云计算、大数据以及区块链等技术的创新发展,使得数据资源的存储、计算和应用需求快速扩张,特别是ChatGPT技术推广进一步催生了AI算力等大功率应用场景加速落地。作为信息基础设施的数据中心及通信设备承担的计算量越来越大,对计算效率的要求也越来越高,国内包括全球的数据中心建设有望迎来建设高峰。为了应对网络处理性能的挑战,数据中心服务器及通信设备不断提升自身处理能力和集成度,带来了功率密度的节节攀升。这些变化除了带来巨额能耗问题以外,高热密度也给制冷设备和技术提出了更高要求。传统风冷技术面对高热密度场景呈现瓶颈,散热效率已经跟不上计算效率。在此背景下,液冷技术以其超高能效、超高热密度等特点引起行业的普遍关注,是解决散热压力和节能挑战的必由之路。北京防潮液冷价格

- 天津防潮液冷厂家供应 2024-07-01

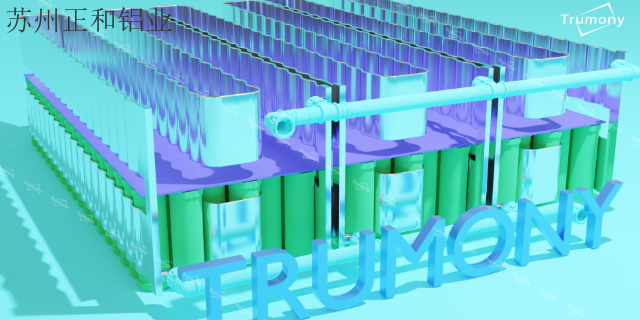

- 江苏动力电池液冷工厂 2024-07-01

- 浙江耐高温液冷供应商 2024-07-01

- 北京品质保障液冷工厂 2024-07-01

- 海南水冷板液冷厂家 2024-07-01

- 海南防潮液冷研发 2024-07-01

- 上海耐高温液冷报价 2024-07-01

- 浙江耐高温液冷工厂 2024-07-01